Autor

Jonas Bühler

Jonas ist Software-Ingenieur bei preML und schreibt über Forschungsprojekte im Bereich Computer Vision und maschinelles Lernen.

Die Fortschritte im Bereich Künstlicher Intelligenz (KI) sorgen auch bei der visuellen Qualitätsinspektion für neue Möglichkeiten zur Automatisierung. Zum Trainieren eines KI-Modells wird jedoch eine große Menge an Daten benötigt, welche zuerst gesammelt und anschließend von Hand annotiert werden müssen. Die Generierung von synthetischen Bildern reduziert die benötigte Datenmenge deutlich und vereinfacht somit den Einsatz von KI-Modellen.

Bild 1: Beispiel Performance Verbesserung mit synthetischen Trainingsdaten.

Hintergrund: KI in der Qualitätskontrolle

Dank Innovationen im Bereich Rechenleistung und Algorithmik hat sich KI in den letzten Jahren rasant entwickelt und insbesondere in der Bildverarbeitung als disruptive Technologie bewiesen.

Die preML GmbH hat schon sehr früh die Vorteile von KI bei der Automatisierung der visuellen Qualitätsprüfung erkannt. Die Gründer, welche zuerst im Bereich des autonomen Fahrens und der Auswertung von Satellitendaten mit KI in Kontakt kamen, gründeten das Unternehmen 2020 am Karlsruher Institut für Technologie (KIT) und liefern heute Lösungen zur Automatisierung der Sichtprüfung in unterschiedlichen Industrien. Dabei wird vorwiegend auf KI-Modelle gesetzt, um z. B. Risse in Betonprodukten zuverlässig zu erkennen, Aluminiumoberflächen zu prüfen, die Vollständigkeit von Montage-Sets zu überprüfen oder Tunnelsegmente zu analysieren. Während hardwareseitig mit am Markt verfügbarer Sensorik gearbeitet wird, verbirgt sich die Innovation in der Software des Unternehmens. Basierend auf einer eigenen Software-Infrastruktur können schnell und kostengünstig KI-Modelle trainiert und als Echtzeitanwendungen ausgeliefert werden. Für die Kunden bringt das gleich mehrere Vorteile. Anwendungssysteme sind kostengünstiger, individueller und flexibler als herkömmliche Systeme. Da es sich bei KI um ein aktives Forschungsgebiet handelt, bei dem es regelmäßig zu neuen Durchbrüchen kommt, kommen immer wieder neue Themen auf. So auch die Nutzung von künstlichen, oft „synthetisch” genannten Bildern für das Training von KI-Modellen. Im Folgenden werden Einblicke in das Training von KI-Modellen mit synthetischen Bildern anhand einer realen Anwendung aus dem Spritzgussbereich gegeben.

Problem: Sammeln und Annotieren von Trainingsdaten

Eine der größten Hürden beim Einsatz von KI ist die Notwendigkeit einer großen Anzahl an Trainingsdaten für KI, speziell für Deep Learning-Ansätze, einem Teilgebiet des maschinellen Lernens, welches komplexe Mustererkennung und -interpretation ermöglicht. Selbst beim Einsatz vortrainierter Netze, also neuronaler Netzwerke, die bereits auf großen Bild-Datensätzen trainiert wurden und als Grundlage für spezifische Aufgaben dienen können, wird weiterhin eine nicht unerhebliche Menge an Trainingsdaten benötigt.

Für die Praxis bedeutet das gleich mehrere Probleme. Erstens, ist es in der Industrie schwierig und kostenintensiv, viele Bauteile mit möglichst allen bekannten Fehlerbildern zu erhalten. Des Weiteren ist das Sammeln und Annotieren von Trainingsdaten zeitaufwendig und fehleranfällig. Erst müssen mit einem Kameraaufbau viele Bilder aufgenommen werden. Anschließend müssen diese einzeln und möglichst konsistent annotiert werden. Dabei lässt sich manuelle Arbeit nicht vermeiden und es kommt immer wieder zu Randfällen, bei denen menschliche Bearbeiter oder Experten unterschiedlich, und damit inkonsistent, entscheiden, ob ein Fehler vorliegt oder nicht. Da die KI-Modelle jedoch nur so gut sind wie die Trainingsdaten, mit denen sie trainiert wurden, haben solche Fehler einen negativen Einfluss auf die Performance.

Lösungsansatz: Generierung von synthetischen Bildern

Für die individuellen Anwendungsfälle von preML bei meist mittelständischen Unternehmen sind hohe Kosten bei der Trainingsdatensatz-Erstellung oft nicht tragbar und führen zur Nichtumsetzung von Projekten. Das Unternehmen hat sich deshalb in den letzten Jahren mit Möglichkeiten beschäftigt, den Aufwand zum Einsatz eines neuen KI-Modells zu reduzieren. Ein in der Praxis bisher noch wenig eingesetzter Ansatz ist die Erstellung von synthetischen Datensätzen. Dazu werden auf Grundlage von CAD-Dateien mittels einer Grafiksoftware synthetische Bilder der Bauteile mit den gewünschten Defekten generiert. Dadurch wird die benötigte Menge an echten Bildern deutlich reduziert.

Arbeitsablauf: Anwendungsbeispiel aus der Kontrolle von Spritzgussteilen

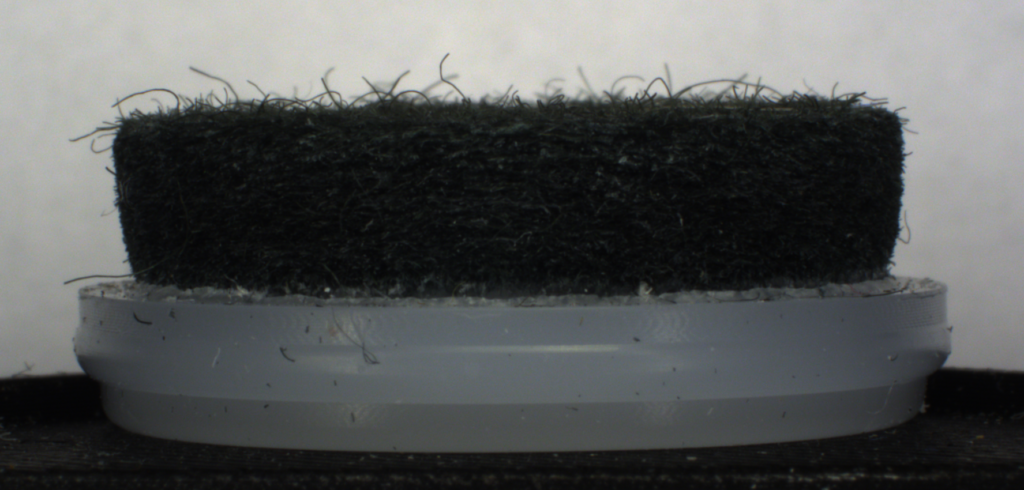

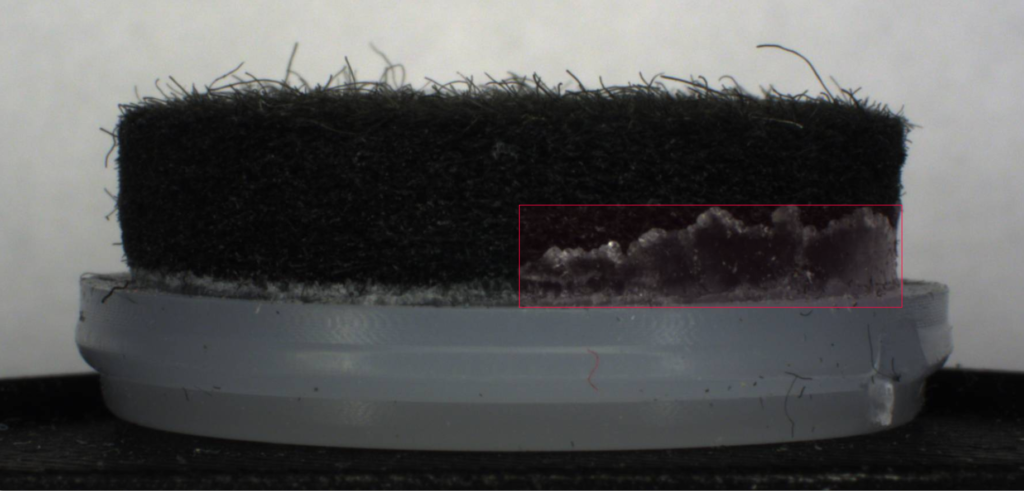

Die Technologie kann zum Beispiel zur Automatisierung der Qualitätskontrolle von Spritzgussteilen genutzt werden. Im spezifischen wird in einem Spritzgussverfahren ein Filzelement umschlossen, um hochwertige Möbelgleiter herzustellen. Dabei kann es zu sogenannten Überspritzungen kommen. Diese führen im schlimmsten Fall zu Beschädigungen an Böden. Diese Überspritzungen sollen durch ein KI-Modell erkannt und lokalisiert werden, sodass die fehlerhaften Möbelgleiter automatisch aussortiert werden können.

Bild 2: umgedrehter Möbelgleiter von der Seite mit geringer (akzeptabler) Überspritzung

Bild 3: umgedrehter Möbelgleiter von der Seite mit deutlicher Überspritzung (rot markierte Box)

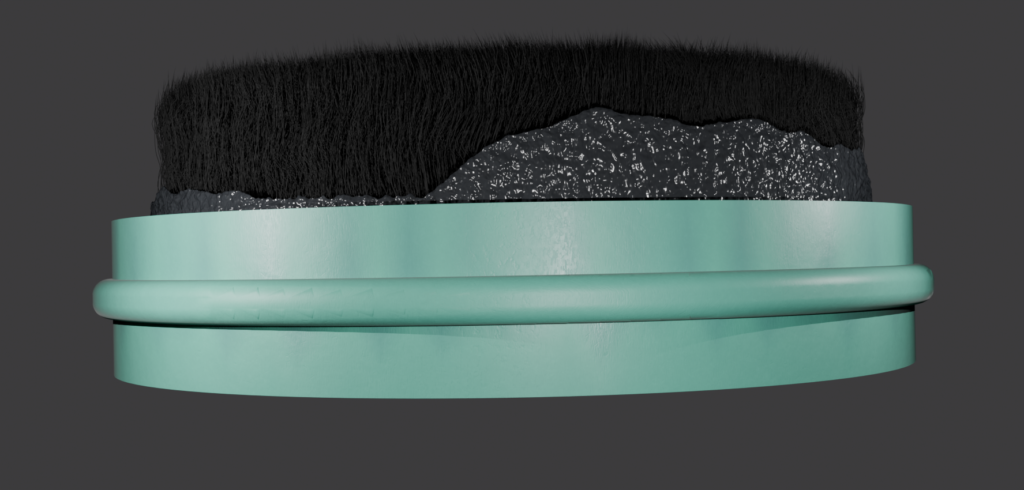

Zur Generierung von synthetischen Bildern wird im ersten Schritt das vorhandene CAD-Modell des Möbelgleiters konvertiert, um es in die Grafiksoftware Blender zu importieren. Dort werden auf das 3D-Modell verschiedene Texturen für den Kunststoff und den Filz angewandt, die dem echten Material möglichst nahekommen. Auch weitere Parameter wie zum Beispiel die Beleuchtung oder der Hintergrund können individuell angepasst werden.

Bild 4: Synthetisch generiertes Bild eines Möbelgleiters

Anschließend können verschiedene Arten von Fehlern dargestellt werden, in unserem Falle eine zufällig generierte Überspritzung. Abhängig von der Art des Fehlers und dem vorliegenden Objekt kann es hierbei notwendig sein, die Darstellung des Fehlers für den Einzelfall anzupassen bzw. zu implementieren.

Bild 5: Synthetisch generiertes Bild mit problematischer Überspritzung

Dieses Verfahren hat mehrere Vorteile: Zum einen können in kurzer Zeit beliebig viele Bilder erzeugt werden. Diese Bilder werden beim Generieren automatisch und konsistent annotiert, sodass keine manuelle Nachbearbeitung mehr notwendig ist. Dabei können auch selten auftretende Fehler in großer Menge und Variation erzeugt werden.

Um das Potential synthetischer Bilder bestmöglich ausnutzen zu können, gibt es eine Vielzahl an Parametern, die beliebig verändert werden können. Auch Modifikationen, die in der Praxis schwer nachzustellen sind, z. B. verschiedene Farben des Materials, können bei synthetisch erzeugten Bildern in vielen Fällen problemlos eingestellt werden.

Evaluation: Mehr Variationen bringen Vorteile im Anwendungsbeispiel

Für den finalen Datensatz, bestehend aus 147 echten und 250 synthetischen Bildern, wurden verschiedene Tests durchgeführt, wie sich die Performance bei einer unterschiedlichen Anzahl von synthetischen und echten Bildern verhält.

Dabei wurden die echten Bilder zu zwei Dritteln zum Trainieren und Validieren genutzt und zu einem Drittel zum Bestimmen der Performance, die Synthetischen ausschließlich zum Trainieren.

Bei den Experimenten hat sich gezeigt, dass sich beim Training mit ausschließlich synthetischen Bildern bereits erste Erfolge zeigen, die für den Praxiseinsatz jedoch noch nicht ausreichend sind. Für zuverlässige und stabile Ergebnisse werden in diesem Anwendungsfall echte Daten benötigt. Allerdings kommt es bereits bei wenigen echten Bildern zu einer deutlichen Steigerung der Ergebnisse.

Auch wenn man bereits einige echte Bilder gesammelt hat, kann sowohl die Erkennung von Fehlern als auch die Lokalisierung der Fehler durch künstliche Daten weiter verbessert werden.

Diagramm 1: Vergleich der Performance mit und ohne künstliche Bilder, bei variierender Anzahl echter Bilder in den Trainingsdaten. mAP@50 ist eine Performance-Metrik. Dargestellt sind die Durchschnitte aus jeweils 10 Experimenten.

Ausblick: Zukunft der KI-Qualitätskontrolle mit synthetischen Daten

Die Erzeugung synthetischer Bilder hat das Potential, die visuelle Qualitätsinspektion weiter zu verbessern und noch kostengünstiger zu gestalten. Die Bilder können in der Anfangsphase eines Projekts dazu genutzt werden, auch bei nur sehr wenigen echten Daten schnell erste Ergebnisse vorweisen zu können. Auch in einer späteren Projektphase können die Daten nützlich sein, um die Ergebnisse weiter zu verbessern, oder das KI-Modell für neue Produktvarianten vor einem Produktwechsel nachzutrainieren.

Ob sich der Einsatz dieser Methode bei einem Projekt lohnt, hängt dabei unter anderem davon ab, wie leicht sich insbesondere die Fehler darstellen und variieren lassen. Außerdem ist es entscheidend, wie aufwändig es ist, echte Fehlerbilder aufzunehmen und zu annotieren. In Zukunft plant preML in weiteren Projekten auf synthetische Daten aufzubauen. Wegen der notwendigen Expertise im Bereich Grafikdesign und der hohen Variabilität in den zu erzeugenden Fehlerbildern, werden synthetische Daten aber zuerst einmal ein internes Werkzeug bleiben, welches bei passenden Anwendungsfällen genutzt wird, oder als Entwicklungsservice angefragt werden kann.

Dieser Artikel erschien zuerst in der QZ Ausgabe 7/2024 sowie online.

Einige Entwicklungen im Bereich syntethische Daten bei der preML GmbH wurden im Forschungsprojekt CAD2SYNTH im Förderprogram InvestBW des Ministeriums für Wirtschaft, Arbeit und Tourismus Baden-Württemberg gefördert.

Autor

Jonas Bühler

Jonas ist Software-Ingenieur bei preML und schreibt über Forschungsprojekte im Bereich Computer Vision und maschinelles Lernen.