Autor

Lucas Steinmann

Lucas ist der CTO von preML und verantwortlich für die technische Entwicklung innerhalb von preML. Ich bin begeistert von allem, was mit Computer Vision zu tun hat.

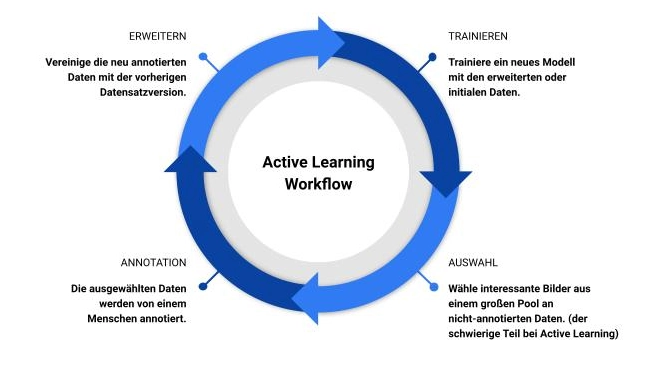

Beim Active Learning geht es primär darum, die Datenmenge zu reduzieren, die für das Training eines KI-Modells benötigt wird. Dazu wird ein KI-Modell verwendet, um gezielt die Daten auszuwählen, die für das Training besonders relevant und lehrreich sind. „Interessant“ bedeutet in diesem Zusammenhang, dass die ausgewählten Daten dem Modell einen großen Lernfortschritt ermöglichen. Typischerweise handelt es sich um bisher nicht gesehene oder besonders herausfordernde Szenarien – etwa eine ungewöhnliche Verkehrssituation für ein Modell zum autonomen Fahren. Durch die Fokussierung auf solche interessanten Daten kann die Anzahl der zu annotierenden Daten reduziert werden, was wertvolle Zeit bei der Annotation spart.

Bild 1: Schematische Darstellung des Active Learning Workflows. Der Workflow wird mit dem Labeln von manuell oder zufällig ausgewählten Daten angestoßen.

Data Poisoning und Active Learning

Der Active Learning-Prozess bietet nicht nur Effizienzvorteile, sondern kann auch dabei helfen, Data Poisoning – also das absichtliche Manipulieren von Trainingsdaten – zu erkennen. Um festzustellen, welche Daten „interessant“ für das Training sind, berechnen Active Learning-Methoden die Unsicherheit des Modells bei bestimmten Datenpunkten. Ein hoher Unsicherheitswert deutet darauf hin, dass das Bild viele unbekannte oder komplexe Informationen enthält.

Typischerweise sinkt die durchschnittliche Unsicherheit des Modells über Zeit, da es zunehmend besser darin wird, die Daten zu erkennen und zu verarbeiten. Sollte jedoch die Unsicherheit plötzlich ansteigen, könnte dies auf eine Veränderung der Datenqualität hinweisen. Diese Veränderung muss nicht zwangsläufig durch Data Poisoning verursacht werden – externe Faktoren wie eine schlechtere Bildqualität könnten ebenfalls der Grund sein. Dennoch sollte eine erhöhte Unsicherheit als Warnsignal betrachtet werden, dass die Daten möglicherweise manipuliert wurden.

Besonders relevant ist dies bei selbstlernenden Systemen oder solchen, die von nicht spezialisierten Nutzern trainiert werden. Ein Anstieg der Unsicherheit kann ein Hinweis darauf sein, dass das System Daten verwendet, die das Modell „verwirren“ könnten. Hier könnte das Training unterbrochen werden, um nähere Untersuchungen anzustellen. Da der Zustand des Modells nach jeder Iteration gespeichert wird, lässt sich im Ernstfall ein früherer, sicherer Modellzustand wiederherstellen. So können auch der Zeitpunkt und die Quelle der schädlichen Daten genau ermittelt werden.

Anwendungsfall: Fehlererkennung bei Platinen

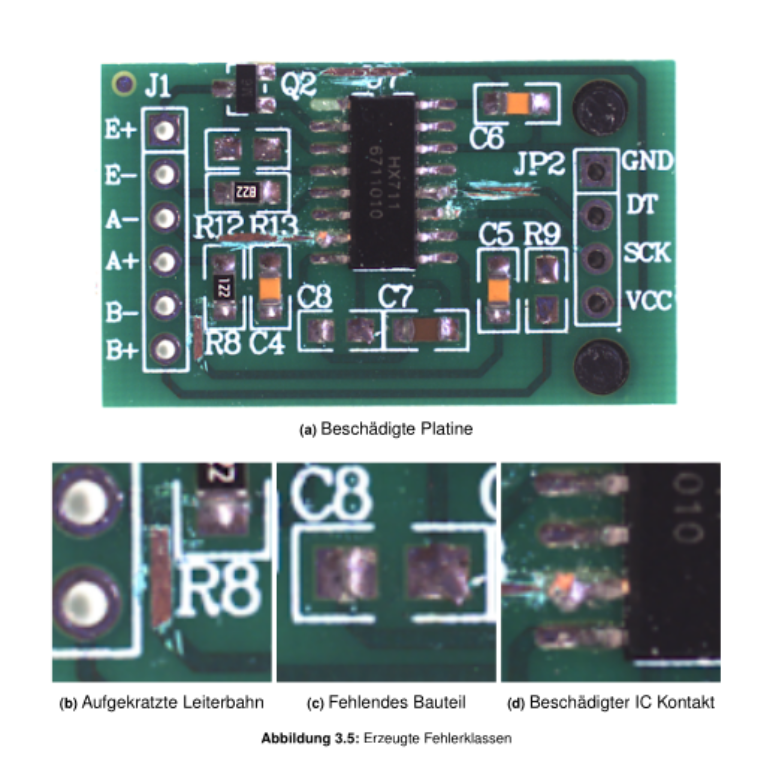

Ein interessantes Beispiel für den Einsatz von Active Learning ist die Fehlererkennung auf Platinen. Bei preML wurde ein spezielles Kamerasystem verwendet, um Bilder von Platinen aufzunehmen, auf denen absichtlich Fehler erzeugt wurden. Zur Berechnung der Unsicherheit wurden Modell-Ensembles verwendet – das heißt, mehrere Modelle mit leicht unterschiedlichen Vorhersagen wurden kombiniert. Der daraus abgeleitete Consensus Score misst die Abweichung der einzelnen Vorhersagen und quantifiziert so die Unsicherheit.

Bild 2: Beispieldaten und Defekte des Anwendungsfalls einer beschädigten Platine.

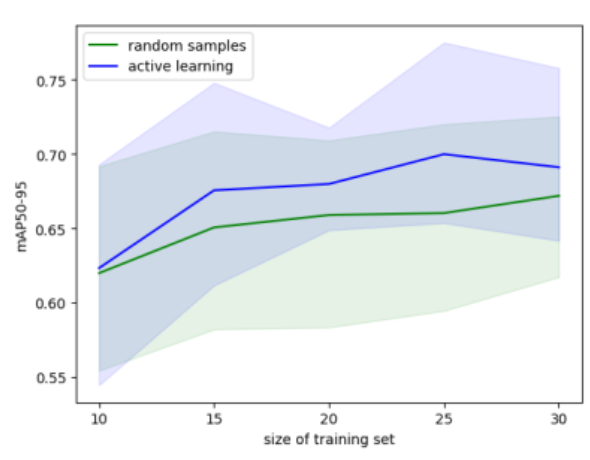

Die Bilder mit den höchsten Unsicherheitswerten wurden priorisiert und für das Training verwendet. Dadurch konnte der benötigte Datenumfang um bis zu 50 % reduziert werden, ohne dass die Qualität des Modells darunter litt.

Bild 3: Ergebnis der Studie: Mit nur 15 Bildern im Active Learning Workflow wurde eine bessere Performance als beim regulären Training erreicht.

Fazit

Active Learning kann den Datenbedarf erheblich reduzieren, selbst wenn nur kleine Datensätze zur Verfügung stehen. Besonders in Bereichen wie der automatischen Qualitätskontrolle ist es ein wertvolles Werkzeug. Bei preML wird Active Learning nicht nur zur Effizienzsteigerung, sondern auch zur Erkennung potenziell fehlerhafter oder manipulierte Daten eingesetzt. Dies macht Active Learning zu einer attraktiven Methode für Unternehmen, die ihre Trainingsdaten optimal nutzen und gleichzeitig vor Data Poisoning geschützt sein möchten.

Autor

Lucas Steinmann

Lucas ist der CTO von preML und verantwortlich für die technische Entwicklung innerhalb von preML. Ich bin begeistert von allem, was mit Computer Vision zu tun hat.